DGIST, 대학원 대통령장학금 4명 선정 쾌거

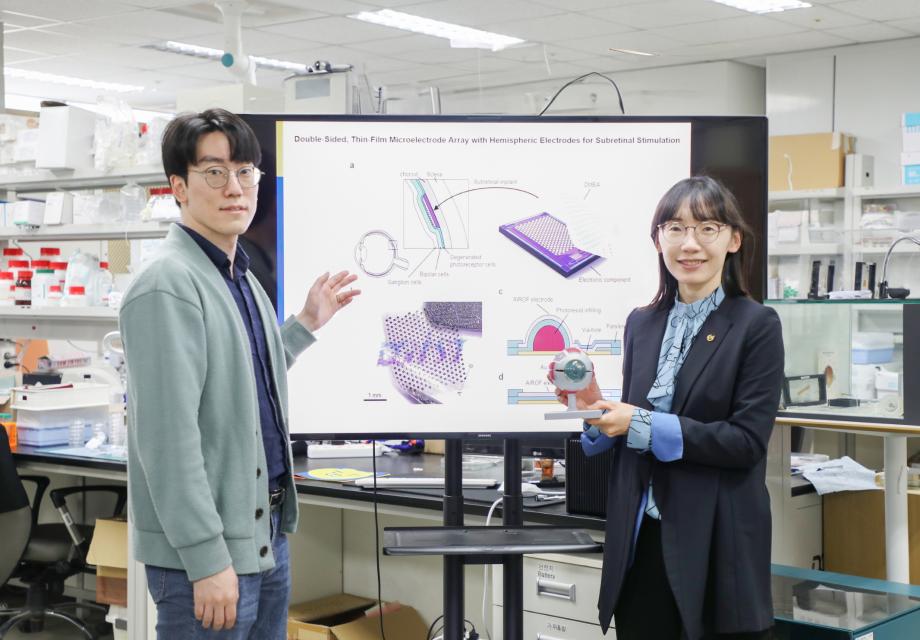

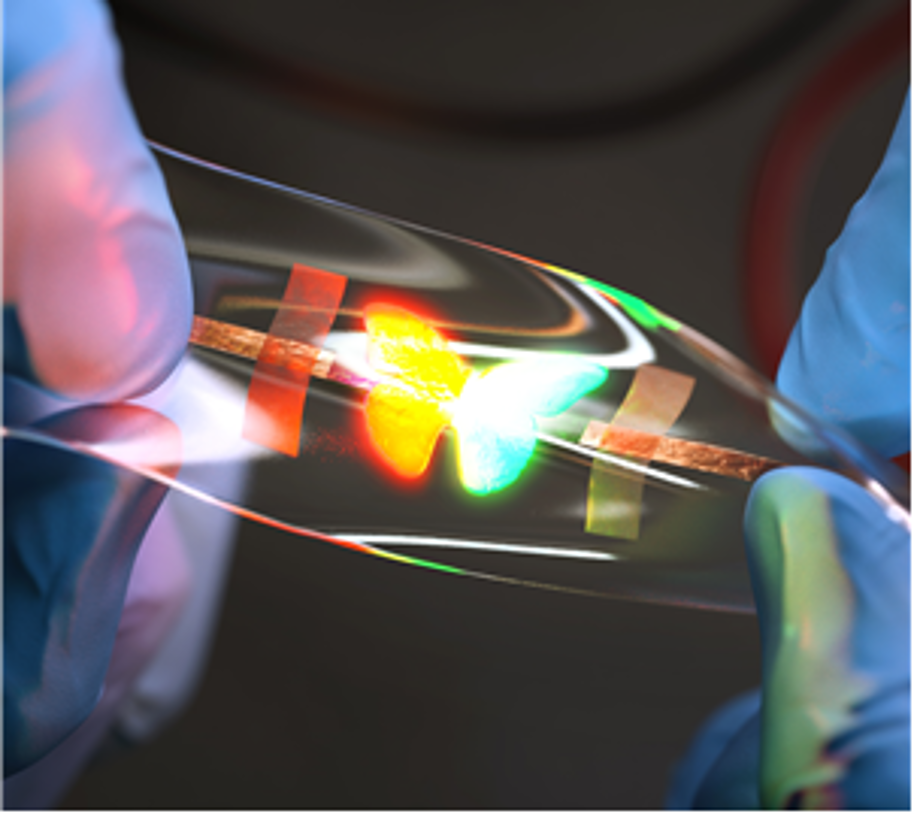

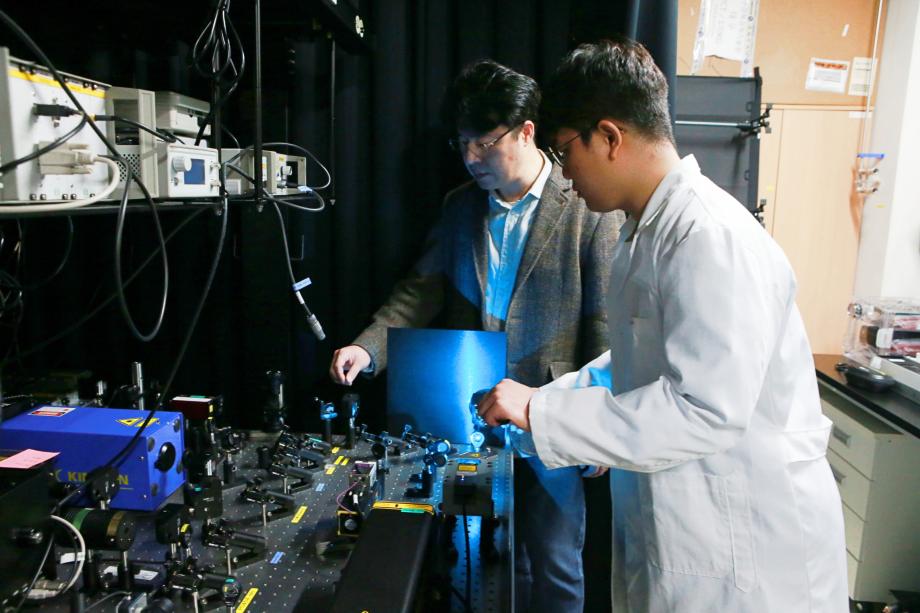

- 장학금 선발 경쟁률 약 25:1을 뚫고, ICT융합 분야 3명, 생명과학 분야 1명 선정[(왼쪽부터) DGIST 신희재, 마현종 석박사통합과정생, 김지유 석사과정생, 남채린 석박사통합과정생]DGIST(총장 이건우) 대학원생 4명이 제1기 대학원 대통령과학장학금에 선정됐다.대학원 대통령과학장학금은 이공계 대학원생에 대한 차별화된 지원을 위해 만들어진 장학사업으로, 올해 신설됐다. 신규 장학생 선발인원은 박사과정생 70명(신입생 30명, 재학생 40명), 석사과정생 50명(신입생 25명, 재학생 25명)으로 총 120명이다. 선발 과정은 대학원생 개인 신청 접수 후 1단계 서류 심사, 2단계 심층면접 심사 순으로 진행됐으며, 올해 선발 경쟁률은 약 25 : 1로 집계됐다.분야별 선발인원은 신청 접수 인원에 비례 배분해 대분류 기준으로 ▲자연과학 총 19명(박사 10명, 석사 9명), ▲생명과학 총 24명(박사 16명, 석사 8명), ▲공학 총 30명(박사 17명, 석사 13명), ▲ICT융합연구 총 47명(박사 27명, 석사 20명)으로, DGIST는 ICT융합연구에서 3명(박사 재학생 2명, 석사 재학생 1명), 생명과학에서 1명(석사 신입생 1명)이 선정됐다.로봇및기계전자공학과 신희재 석박사통합과정생은 신경손상 기능복원 및 인간증강 기술로의 응용을 위한 재생신경인터페이스 개발을 주제로 다학제 융합복합(대분류 ICT융합연구, 박사 재학생) 분야에 선정됐다. 신희재 학생은 말초신경계의 생리학적 기전과 의학적 접근을 고려한 신경과학 및 신경공학 융합연구를 통해 신경손상 환자를 위한 바이오닉 상하지 개발에 적용될 재생신경인터페이스 연구를 수행할 예정이다.에너지공학과 마현종 석박사통합과정생은 초고분해능 실시간 투과전자현미경 분석을 통한 높은 저장용량흡착속도를 갖는 수소 저장 나노 소재 개발을 주제로 에너지환경 융합복합(대분류 ICT융합연구, 박사 재학생) 분야에 선정됐다. 마현종 학생은 친환경 미래 에너지원으로 주목받고 있는 수소를 이용한 수소경제 실현을 위하여 높은 저장용량흡착속도를 갖는 수소 저장 나노 소재 개발 연구를 수행할 예정이다.전기전자컴퓨터공학과 김지유 석사과정생은 High-level의 자율주행 구현을 위한 차량 통신 연구를 주제로 통신(대분류 ICT융합연구, 석사 재학생) 분야에 선정됐다. 김지유 학생은 자율주행 시스템의 안정성과 성능 향상 및 교통 소외 지역에 편의성을 제공할 수 있도록 자율주행 서비스에서 저지연, 고신뢰 데이터 전송 및 처리를 지원하기 위한 연구를 수행할 예정이다.뉴바이올로지학과 남채린 석박사통합과정생은 난치암을 포함한 다양한 질병에 해답을 제시하는 항체치료제 개발 연구를 주제로 분자생명(대분류 생명과학, 석사 신입생) 분야에 선정됐다. 남채린 학생은 난치성 암을 효과적으로 치료할 수 있도록 치료 타깃에 대한 높은 선택성과 결합력을 가지는 항체 형태의 약물을 개발해 종양 미세환경에서 억제된 면역 환경을 활성화하는 연구를 수행할 예정이다.DGIST 이건우 총장은 DGIST 대학원생이 대통령과학장학금에 선정되어 매우 기쁘다며, 선발된 학생들이 학업에 전념해 세계 최고 연구인력으로 성장할 수 있도록 DGIST에서도 적극 지원하겠다고 밝혔다.한편, 올해로 창립 20주년을 맞은 DGIST는 과학기술정보통신부 직할 과학기술원으로 2011년과 2014년 각각 대학원과 학부과정을 개설한 이후 지금까지 약 1,900명의 융복합 과학 인재를 배출해오고 있다. 최근 발표된 QS세계대학평가 연구력 지표인 교원 1인당 논문 피인용 부문에서 세계 7위를 달성해 우수성을 부각하기도 했다. 또한, 최근 세계 최대의 공학교육 학술행사인 2025 세계공학교육포럼 및 공과대학장 세계대회(WEEF-GEDC 2025) 유치에 성공하면서 세계적인 대학으로 도약하기 위한 발판을 마련하고 있다.